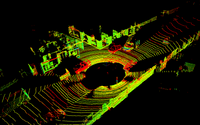

Lidar Hinderniserkennung

Im Zuge dieses Projektes wurde ein Programm geschrieben, mit dem Lidar Punktwolken von automatisierten Fahrzeugen analysiert werden. Diese Analyse beinhaltet zum einen das Filtern der Punktwolke, das Segmentieren von Objekten und befahrbarer Straße und das Clustern von den Objekten, einschließlich Ziehen von Bounding Boxen. Die daraus gewonnenen Informationen können anschließend in das Umfeldmodell einfließen.

Fahrspurerkennung

Bei diesem Projekt wird auf Basis von Kamerabildern die zu befahrende Spur erkannt. Dies geschieht durch klassische Ansätze der Computer Vision, wie der Kantenerkennung. Zusätzlich wird eine Abschätzung des Kurvenradius und der Abweichung des Egofahrzeugs von der Spurmitte berechnet.

Fußgängerperzeption

Ausgehend von einem Kamerastream können mit Hilfe dieses Algorithmus Fußgänger erkannt und verfolgt werden. Zusätzlich wird mit Hilfe eines neuronalen Netzes zu jeder Person eine Orientierung abgeschätzt. In weiteren Versuchen wurde ein rekurrentes neuronales Netz implementiert, um auf Basis mehrerer vorheriger Bilder zu erkennen, ob eine Person geht oder steht. Diesen Algorithmus habe ich im Zuge meiner Studienarbeit am Institut für Fahrzeugtechnik erstellt. In einer Weiterentwicklung wurde eine Tiefenabschätzung implementiert, um Personen mit einer Monokamera im dreidimensionalen Raum zu lokalisieren.

Trajektoriengenerierung

Der hier implementierte Algorithmus ist in der Lage, Trajektorien zu generieren und ein Fahrzeug in einer Simulationsumgebung sicher zu führen. Dabei überholt das Egofahrzeug andere Fahrzeuge, sofern ein anderes Fahrzeug auf der gleichen Spur langsamer fährt und eine benachbarte Spur frei ist. Wenn keine andere Spur frei ist, bremst das Egofahrzeug und hält einen Sicherheitsabstand solange ein, bis ein Überholvorgang möglich ist.

Partikelfilter

Im Zuge dieses Projektes wird ein Partikelfilter implementiert. Mit diesem soll ein Fahrzeug ausgehend von einem initialen GPS Signal mit Hilfe von Landmarken und Sensorfusion in einem Simulator lokalisiert werden. Diese Lokalisierung soll dabei über 100 Sekunden erfolgen und darf nur eine geringe Abweichung haben.

Lenkwinkel abschätzen

In diesem Projekt ist ein Fahrzeug in der Lage, selbstständig durch einen Kurs zu fahren. Die Entscheidung über den Lenkwinkel wird durch Kamerabilder getätigt. Hierzu wurden zunächst manuell einige Runden mit dem Fahrzeug über die Strecke gefahren, um Trainingsdaten zu sammeln. Anschließend wurde ein neuronales Netz trainiert, das in der Lage ist, zu einem einkommenden Kamerabild einen Lenkwinkel vorzuschlagen.

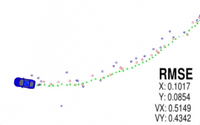

Kalman Filter

Bei diesem Projekt wurde ein Extended Kalman Filter programmiert, der in der Lage ist, Daten von Radar und Lidar zu nutzen und damit Objekte zu verfolgen. Zusätzlich wird der Root Mean Squared Error (RMSE) berechnet, bei dem die Ergebnisse des Filters mit den wahren Daten abgeglichen werden. Dieser Fehler soll unter 0,11 liegen.

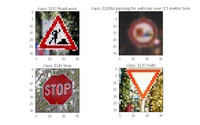

Verkehrszeichenerkennung

Hier wurde ein neuronales Netz aufgestellt, mit dem deutsche Verkehrszeichen klassifiziert werden können. Für das Training wurde manuell Image Augmentation eingeführt, um den Datensatz zu erweitern. Anschließend wurde ein eigenes CNN aufgebaut, trainiert und an dem Testdatensatz getestet.

PID Controller

Hier wurde ein PID Controller implementiert, mit dessen Hilfe ein Fahrzeug entlang einer Trajektorie gesteuert werden soll. Das Fahrzeug darf dabei die Spurbegrenzungen nicht überfahren. Dafür wurden die Hyperparameter des Controllers für P, I und D Anteil solange in einem Finetuning Prozess angepasst, bis eine geeignete Kombination gefunden wurde, mit der das Fahrzeug den Kurs abfahren kann.

Hunderassen Klassifizierer

Bei diesem Projekt wurden neuronale Netze trainiert, die in der Lage sind, Hunderassen zu erkennen - zum einen mittels Transfer Learning und zum anderen mit einem von Grund auf neu erstelltem Netz. Zudem kann der Algorithmus Menschen erkennen und eine Hunderasse vorschlagen, die der Person am ähnlichsten sieht.

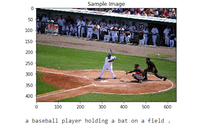

Automatische Bildbeschriftungen

Hier wurde ein neuronales Netz trainiert um Bilder zu analysieren und automatisch eine Beschreibung des Bildes auszugeben. Das neuronale Netz besteht aus einem CNN Encoder, welcher Features aus dem Bild extrahiert, und einem RNN Decoder, der einen Satz auf Basis des Featurevektors erstellt.

SLAM

In diesem Projekt wurde ein zweidimensionaler SLAM Algorithmus (simultaneous localization and mapping) implementiert. Mit diesem soll ein Roboter in der Lage sein, sich zu lokalisieren und mit der Zeit auf Basis von Sensordaten die erkundete Welt zu rekonstruieren.

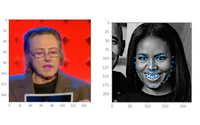

Keypoints in Gesichtern erkennen

In diesem Projekt wird ein neuronales Netz erstellt, das in der Lage ist, charakteristische Punkte in Gesichtern zu entdecken. Mit Hilfe dieser Punkte können beispielsweise Filter entwickelt oder Emotionen und Posen erkannt werden.

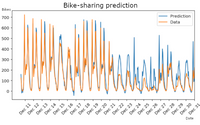

Bike-sharing Vorhersage

Bei diesem Projekt wurde ein neuronales Netz von Grund auf programmiert. Hierbei wurden keine gängigen Bibliotheken wie TensorFlow oder PyTorch genutzt, sondern es wurden manuell Algorithmen wie der Backpropagation Algorithmus oder das Aktualisieren der Gewichte implementiert. Mit diesem Netz kann eine Vorhersage über Bike-sharing Zahlen getroffen werden.